В математике понятие погрешности играет важную роль в определении точности вычислений и измерений. Абсолютная погрешность - это одна из мер, которая количественно определяет разницу между фактическим значением и измеренным или рассчитанным значением. Она дает ценное представление о точности метода или прибора.

Уравнение абсолютной погрешности выражается как абсолютное значение разницы между фактическим значением и измеренным или рассчитанным значением. Математически оно может быть выражено следующим образом.

Абсолютная погрешность = |фактическое значение - измеренное или рассчитанное значение|.

Эта формула может быть использована для определения того, насколько далеко измеренное или рассчитанное значение находится от фактического значения, независимо от направления. Использование абсолютных значений гарантирует, что погрешность всегда положительна.

Абсолютная ошибка особенно полезна, когда важно не направление ошибки, а ее общая величина. Она часто используется для оценки точности экспериментальных результатов или численных расчетов в различных областях науки и техники, таких как физика, химия и статистика.

Формула абсолютной погрешности

В математике формула абсолютной погрешности используется для измерения разницы между оценкой величины и ее истинным значением. Она обеспечивает количественную меру точности приближения или измерения. Формула рассчитывает абсолютную погрешность путем вычитания оценочного значения из истинного и получения абсолютного значения результата.

Формула для абсолютной погрешности получается следующим образом.

Абсолютная ошибка = | истинное значение - расчетное значение|

Абсолютная ошибка всегда положительна или равна нулю, так как функция абсолютного значения гарантирует, что результат неотрицателен. Она представляет собой величину разницы между истинным значением и расчетным значением, без учета направления ошибки.

Формула абсолютной ошибки широко используется в различных областях физики, инженерии, статистики и экономики. Она особенно полезна в ситуациях, когда точность измерения или оценки имеет решающее значение. Расчет абсолютной погрешности позволяет оценить надежность данных и принять обоснованные решения с учетом уровня неопределенности.

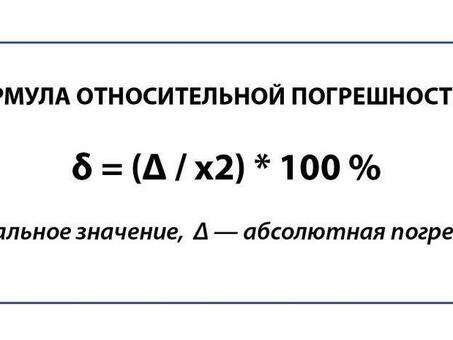

Также важно отметить, что формула абсолютной ошибки является базовой мерой погрешности и не учитывает относительный размер ошибки по сравнению с истинным значением. Для оценки относительной точности приближения математики часто используют формулу относительной погрешности, в которой абсолютная погрешность делится на истинное значение.

Что такое абсолютная погрешность?

Абсолютная погрешность - это математическое понятие, используемое для измерения точности приближения или оценки. Она представляет собой разницу между измеренным значением и истинным значением величины. Абсолютная погрешность определяется как положительное значение разности между измеренным и истинным значением.

Формула: формула абсолютной погрешности такова.

Абсолютная погрешность = |измеренное значение - истинное значение|.

Интерпретация: абсолютная погрешность показывает, насколько далеко измеренное значение находится от истинного. Меньшая абсолютная ошибка указывает на более точное измерение или оценку, большая абсолютная ошибка указывает на менее точное измерение или оценку.

Пример: вы измеряете длину карандаша, и фактическая длина составляет 15 сантиметров. Если измерение составляет 14,5 сантиметра, то абсолютная погрешность равна 0,5 сантиметра.

Единицы измерения: Единицы измерения абсолютной погрешности те же, что и единицы измерения или оценки величины. Например, если длина измеряется в метрах, то единицей абсолютной погрешности также являются метры.

Важность: абсолютная погрешность является важным понятием, поскольку позволяет количественно оценить точность измерения и оценки. Она используется для оценки надежности и достоверности экспериментальных и наблюдательных данных в различных областях, таких как физика, инженерия и статистика.

Как рассчитать абсолютную погрешность?

Абсолютная погрешность - это понятие, используемое в математике для измерения степени отклонения вычисленного или измеренного значения от истинного или ожидаемого. Это численная разница между расчетным и фактическим значением. Абсолютная погрешность часто выражается как положительное значение, поскольку она представляет собой величину отклонения независимо от направления.

Для расчета абсолютной ошибки необходимо иметь как расчетное, так и истинное значение. Формула для расчета абсолютной погрешности выглядит следующим образом

Абсолютная ошибка = |оценочное значение - истинное значение|

Абсолютная погрешность может быть рассчитана во многих ситуациях, включая научные эксперименты, статистический анализ и простые повседневные расчеты. Например, если вы измеряете длину объекта и знаете, что фактическое значение равно 10 сантиметрам, а полученное измерение равно 11 сантиметрам, абсолютная погрешность составит |11 - 10|. = 1 сантиметр

Важно отметить, что абсолютная погрешность является мерой точности, а не погрешности. Меньшая абсолютная погрешность указывает на более близкое приближение к истинному значению, в то время как большая абсолютная погрешность указывает на большее отклонение. Поэтому в большинстве ситуаций желательно минимизировать абсолютную погрешность.

Комментарии