Метрология - это наука об измерениях, и точность является важным элементом любого процесса измерения. Инженерам и ученым часто требуется определить степень неопределенности или ошибки в измерении. Абсолютная погрешность - это распространенный метод, используемый в метрологии для количественной оценки разницы между измерением и его истинным значением.

Формула абсолютной погрешности - это математическое уравнение, которое обеспечивает количественную меру погрешности измерения. Она рассчитывается путем вычитания истинного значения из измеренного и взятия абсолютного значения разницы. Используя эту формулу, можно легко оценить точность измерения, поскольку она дает единое значение величины ошибки.

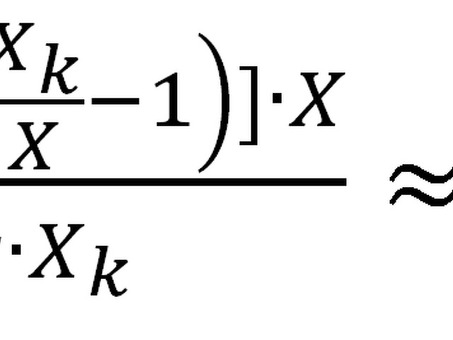

Уравнение абсолютной погрешности можно записать следующим образом.

Абсолютная ошибка = |измеренное значение - истинное значение|.

Например, предположим, ученый измеряет длину объекта 10 сантиметров, но фактическая длина составляет 9,5 сантиметров. Абсолютная погрешность рассчитывается следующим образом

Абсолютная ошибка = |10 см - 9,5 см|= 0,5 см.

В данном случае абсолютная ошибка равна 0,5 см, что означает отклонение от истинного значения на 0,5 см. Формула абсолютной погрешности позволяет инженерам и ученым сравнивать точность различных методов измерения, оценивать надежность оборудования и принимать обоснованные решения на основе уровня погрешности измерений.

Понимание абсолютной погрешности

Абсолютная погрешность - это важная концепция, которую необходимо понимать, когда речь идет о метрологии. Она означает разницу или отклонение между измеренным значением и истинным или допустимым значением величины или параметра. Абсолютная погрешность дает информацию о точности измерения и помогает оценить надежность измерительной системы.

Для расчета абсолютной погрешности используется простая формула Абсолютная погрешность = Измеренное значение - Истинное значение. В зависимости от того, больше или меньше измеренное значение по сравнению с истинным, результат будет положительным или отрицательным. Это представляет собой величину отклонения и обычно выражается в тех же единицах, что и измеряемая величина.

Рассмотрим пример, иллюстрирующий, как работает абсолютная погрешность. Предположим, у вас есть термометр, который заявляет, что измеряет температуру с точностью ±0,5 градусов Цельсия. Если фактическая температура составляет 25 градусов Цельсия, а термометр показывает 24,8 градуса Цельсия, абсолютная погрешность может быть рассчитана следующим образом

Измеренное значение

Истинное значение

Абсолютная погрешность

24. 8°C

25. 0°C

|-0. 2°C|= 0. 2°C

Это означает, что термометр имеет абсолютную погрешность 0,2 градуса Цельсия, что указывает на то, что его измерения немного ниже истинного значения. Абсолютная погрешность помогает понять уровень точности и прецизионности, который можно ожидать от термометра.

В метрологии для обеспечения надежности измерений важно, чтобы абсолютная погрешность была как можно меньше. Этого можно достичь путем использования высококачественного оборудования, снижения систематических ошибок и применения соответствующих методов калибровки и коррекции. Понимание абсолютной погрешности имеет решающее значение для обеспечения точности и качества измерений в различных областях, таких как машиностроение, наука и производство.

В заключение следует отметить, что абсолютная погрешность - это фундаментальная концепция в метрологии, которая измеряет отклонение или разницу между измерением и его истинным значением. Она помогает оценить точность и надежность измерения и выражается в тех же единицах, что и измеряемая величина. Понимание и минимизация абсолютной погрешности помогает обеспечить точность и достоверность измерений, что ведет к повышению качества и надежности в различных отраслях промышленности.

Расчет абсолютной погрешности

В метрологии абсолютная погрешность - это важное понятие, используемое для оценки точности и достоверности измерений. Она представляет собой разницу между измеренным значением и истинным значением измеряемой величины.

Формула для расчета абсолютной погрешности очень проста. Она включает в себя вычитание истинного значения из измеренного значения для получения результирующего абсолютного значения. Математически это можно выразить следующим образом.

Абсолютная ошибка = |измеренное значение - истинное значение|.

Например, предположим, вы измеряете длину объекта с помощью линейки с минимальным отсчетом в 0,1 сантиметра. Измеренная длина равна 5,7 сантиметра. Истинное значение, полученное с помощью более точных методов измерения, составляет 5,6 сантиметра.

Используя формулу, абсолютная погрешность составляет

Абсолютная ошибка = |5,7 - 5,6|= 0,1 сантиметра.

Как видите, в данном случае абсолютная погрешность равна минимальному отсчету измерительного прибора. Она представляет собой максимальную разницу между измеренным и истинным значением и дает ценную информацию о точности измерения.

Важно отметить, что абсолютная погрешность является скалярной величиной и не имеет направленной составляющей, как относительная погрешность. Она не показывает, переоценивает или недооценивает измеренное значение истинное значение. Однако она помогает оценить общую точность и надежность процесса измерения.

Комментарии