При работе с измерениями и вычислениями важно понимать концепцию абсолютной погрешности. Абсолютная погрешность - это способ количественной оценки разницы между фактическим измерением или вычислением и значением, которое считается истинным или точным. Она позволяет определить степень отклонения отдельного значения от идеального или ожидаемого значения.

Абсолютная погрешность рассчитывается путем взятия абсолютного значения разницы между измеренным или рассчитанным значением и истинным или ожидаемым значением. Она дает возможность оценить уровень точности измерения или расчета. Чем меньше абсолютная погрешность, тем ближе измеренное или вычисленное значение к ожидаемому.

Абсолютная погрешность обычно выражается в тех же единицах, что и измеренное или вычисленное значение. Например, если вы измеряете длину объекта и знаете, что измеренное значение равно 10 сантиметрам, а фактическая длина объекта составляет 9,5 сантиметра, абсолютная погрешность равна 0,5 сантиметра. Это означает, что измерение отклоняется от фактической длины на 0,5 сантиметра.

Абсолютная погрешность является важным понятием в таких областях, как физика, инженерия и статистика, где точные измерения и расчеты имеют решающее значение. Она позволяет ученым и исследователям оценить надежность и достоверность данных и результатов. Понимание и учет абсолютной погрешности помогает обеспечить максимальную точность измерений и вычислений.

Что такое абсолютная погрешность?

Абсолютная погрешность числа - это мера того, насколько измеренное или вычисленное значение далеко от своего истинного значения; это абсолютная разница между двумя значениями. Абсолютная погрешность дает информацию о точности измерения или вычисления.

Чтобы рассчитать абсолютную погрешность, вычтите истинное значение из измеренного или рассчитанного значения и получите полученное абсолютное значение. Например, если истинное значение равно 10, а измеренное - 9, то абсолютная погрешность будет равна |10 - 9| = 1.

Абсолютная погрешность часто используется в науке и технике, где требуются точные измерения. Она позволяет исследователям количественно оценить уровень неопределенности и определить области для улучшения. Минимизируя абсолютную погрешность, ученые и инженеры могут повысить точность расчетов и измерений.

Важно отметить, что абсолютная погрешность не указывает направление ошибки. Она лишь предоставляет информацию о величине разницы между измеренным или рассчитанным значением и истинным значением. Чтобы определить направление ошибки, необходимо проанализировать знак значения или использовать дополнительные методы.

В целом, абсолютная погрешность - это мера точности измерения или вычисления. Она рассчитывается путем взятия абсолютного значения разницы между измеренным или вычисленным значением и истинным значением. Минимизируя абсолютную погрешность, ученые и инженеры могут повысить точность своей работы.

Определение и описание.

Абсолютная погрешность числа - это мера того, насколько далеко число находится от своего истинного или ожидаемого значения. Она рассчитывается путем взятия разности между измеренным и истинным значением. Абсолютное значение этой разности берется для того, чтобы погрешность всегда была положительной.

Абсолютная погрешность часто используется в таких областях, как машиностроение, физика и статистика, где важны точные измерения и вычисления. Она указывает на точность или аккуратность измерения или вычисления.

Например, предположим, вы измеряете длину металлического стержня с помощью линейки. Известно, что фактическая длина стержня равна 50 сантиметрам. Если измеренная длина составляет 52 сантиметра, то абсолютная погрешность равна абсолютной разнице между измеренным значением (52) и истинным (50), то есть 2 сантиметра.

Важно отметить, что абсолютная погрешность не дает информации о направлении погрешности (больше или меньше истинного значения). По этой причине используются абсолютные значения. Если вы хотите узнать направление ошибки, вы можете использовать понятие относительной погрешности, которая представляет собой абсолютную погрешность, деленную на истинное значение.

Абсолютная погрешность может быть выражена в десятичной, процентной или научной нотации. Она также может быть использована для расчета других полезных показателей погрешности, таких как средняя абсолютная погрешность или среднеквадратичная погрешность.

В целом, абсолютная погрешность числа - это мера того, насколько далеко число находится от своего истинного значения. Это полезный инструмент для оценки точности и аккуратности измерений и вычислений в различных областях.

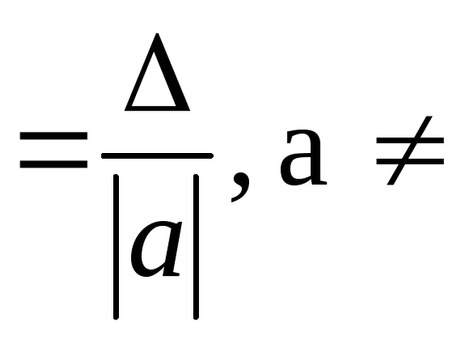

Формулы и расчеты

Формула для расчета абсолютной погрешности числа относительно проста. Она предполагает нахождение разницы между действительным значением числа и его приближением или оценкой. Эта разница выражается как положительное значение, без учета отрицательного знака. Абсолютная погрешность может быть рассчитана по следующей формуле

Абсолютная ошибка = |фактическое значение - приближенное значение|

Чтобы понять, как работает расчет, рассмотрим пример. Предположим, что фактическое значение числа равно 10,5, а приблизительное - 10,2. Для расчета абсолютной ошибки фактическое значение минус приближенное равно 0,3, а абсолютная величина этой разницы также равна 0,3. Таким образом, абсолютная ошибка в данном случае равна 0,3.

Важно отметить, что абсолютная погрешность всегда положительна, так как она представляет собой величину разницы между фактическим и приближенным значениями. Это позволяет сравнивать точность различных приближений без учета направления.

В ситуациях, когда для конкретного значения существует несколько приближений, можно рассчитать среднюю абсолютную ошибку. Для этого необходимо найти абсолютную ошибку каждого приближения, суммировать их и разделить на количество рассматриваемых приближений. Это среднее значение позволяет оценить общую точность.

В целом, формула для расчета абсолютной погрешности числа предполагает нахождение разницы между фактическим значением и приближенным и выражение ее в виде положительного значения, которое можно использовать для сравнения точности различных приближений.

Примеры и применение

Пример 1: Предположим, вы хотите определить абсолютную погрешность при измерении длины карандаша. Измеренное значение составило 14 см, но фактическая длина равна 15 см. Чтобы вычислить абсолютную погрешность, вычтите из измеренной длины фактическую: |14 - 15|= 1 сантиметр. Таким образом, абсолютная погрешность равна 1 сантиметру.

Пример 2: Рассмотрим сценарий взвешивания корзины с фруктами. Весы показывают 3,5 килограмма, но фактический вес составляет 4 килограмма. Абсолютная ошибка в этом случае будет |3,5 - 4|. = 0. 5 килограмма. Следовательно, абсолютная ошибка составляет 0,5 килограмма.

Применение: Абсолютная погрешность часто используется в экспериментальных науках, таких как физика и химия, где важны точные измерения и расчеты. Она помогает исследователям определить точность измерений и надежность экспериментальных результатов. Абсолютная погрешность также полезна в таких областях, как машиностроение и производство, где точные измерения необходимы для контроля качества и производственных процессов.

Разница между абсолютной и относительной погрешностью

При измерении или вычислении точности числа важно учитывать разницу между абсолютной и относительной погрешностью. Эти два термина часто используются в математических расчетах и научных экспериментах для количественной оценки точности измерения или вычисления.

Абсолютная погрешность относится к величине разницы между измеренным или рассчитанным значением и истинным или допустимым значением. Это мера того, насколько измерение или расчеты далеки от истинного значения, независимо от масштаба или величины измеряемой величины. Абсолютная погрешность обычно выражается в тех же единицах, что и измеряемая величина, и может быть положительной или отрицательной.

Относительная погрешность, с другой стороны, учитывает масштаб или величину измеряемой величины. Она определяется как отношение абсолютной погрешности к истинному или допустимому значению. Относительная погрешность - это относительная мера точности измерения или расчета, часто выраженная в процентах или долях. Она дает возможность сравнить точность различных измерений или вычислений, независимо от масштаба или величины.

Для расчета относительной погрешности абсолютную погрешность можно разделить на истинное значение и умножить на 100 (перевести в проценты), либо абсолютную погрешность можно разделить непосредственно на истинное значение. Выбор способа выражения относительной погрешности зависит от конкретной ситуации и условностей, принятых в данном секторе или отрасли.

В целом, основное различие между абсолютной и относительной погрешностью заключается в том, что абсолютная погрешность - это мера разницы между измеренным или рассчитанным значением и истинным значением, в то время как относительная погрешность учитывает масштаб или величину измеряемой величины и представляет собой Относительные меры точности.

Комментарии